Il Pentagono cerca di evitare macchine militari fuori controllo

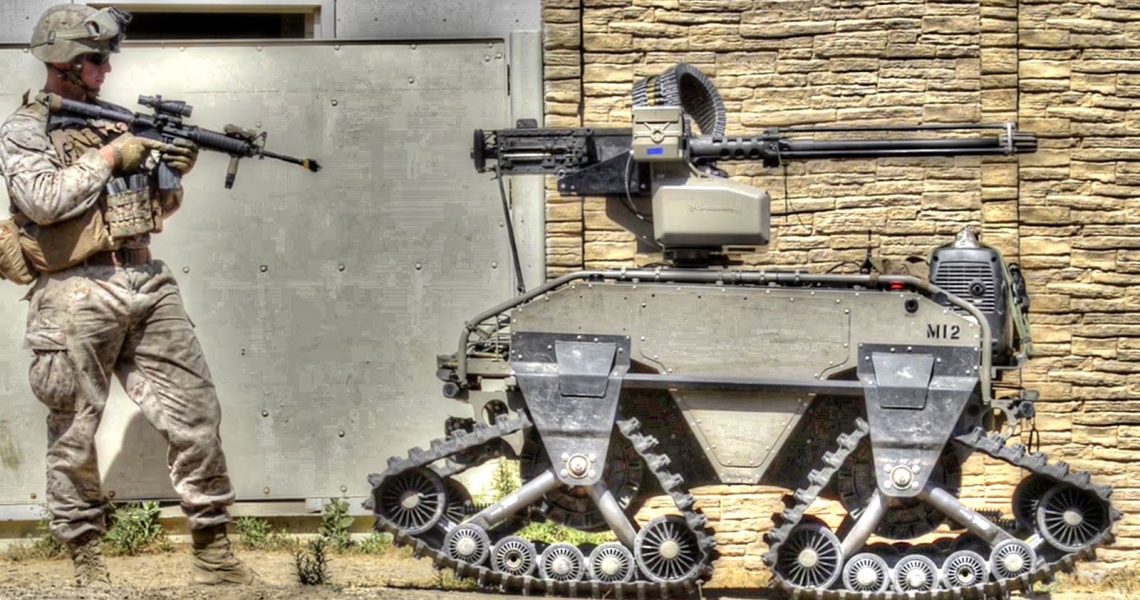

Il Pentagono sta modernizzando attivamente il proprio arsenale con armi autonome, scatenando nell’opinione pubblica il timore di “robot killer” guidati dall’intelligenza artificiale.

Inoltre, la Defense Advanced Research Projects Agency (DARPA) ha recentemente avvertito che i sistemi di intelligenza artificiale sono vulnerabili alla manipolazione attraverso trucchi o segnali visivi. I ricercatori hanno scoperto che anche piccole modifiche agli input dell’apprendimento automatico (ML) di un’IA possono indurla a scambiare un autobus pieno di persone per un carro armato, causando esiti catastrofici sul campo di battaglia.

Per affrontare questi problemi, il Pentagono ha lanciato il programma di ricerca GARD.

Che cos’è esattamente il GARD? Secondo la dott.ssa Hava Siegelmann dell’Information Innovation Office della DARPA, lo scopo di GARD, acronimo di Guaranteeing AI Robustness Against Deception (Garantire la robustezza dell’intelligenza artificiale contro l’inganno), è garantire che i sistemi di ML siano sicuri e non vengano manipolati da metodi di attacco in rapida evoluzione.

Come farà GARD a raggiungere questo obiettivo? Come si legge sul sito web della DARPA, il programma GARD sta attualmente lavorando per stabilire le basi teoriche dei sistemi di ML per identificare le vulnerabilità, migliorare la robustezza del sistema e sviluppare nuovi meccanismi di difesa in grado di proteggere da vari tipi di attacchi.

Inoltre, sta creando una nuova piattaforma di test per valutare l’affidabilità dei sistemi di ML in vari scenari di minaccia dopo l’implementazione delle nuove difese.

by S:D

by S:D